Jedną z istotnych przeszkód, z którą mierzą się instytucje wdrażające rozwiązania oparte na sztucznej inteligencji (SI) jest brak akceptacji i zaufania społecznego. Wiele osób nie ufa i nie chce zaufać działaniom i decyzjom podejmowanym przez SI. Widoczne jest to w tych obszarach, szczególnie regulowanych prawnie, które wiążą się z przetwarzaniem danych wrażliwych. Czyli np. w medycynie, finansach, wymiarze sprawiedliwości. Wyzwanie to finalnie doprowadziło chociażby do rozstrzygnięcia w ramach Unii Europejskiej, wedle którego SI nie będzie mogła mieć przypisanej osobowości prawnej (a warto pamiętać, że osobowość prawną prawo przyznaje chociażby spółkom) oraz, że rozstrzygnięcia algorytmów SI mogą mieć wyłącznie charakter doradczy wobec działań i decyzji człowieka (zgodnie z wnioskiem Komisji Europejskiej z dn. 21.04.2021 o uchwalenie Rozporządzenia Parlamentu Europejskiego i Rady ustanawiającego zharmonizowane przepisy dotyczące sztucznej inteligencji (akt w sprawie sztucznej inteligencji) i zmieniającego niektóre akty ustawodawcze Unii). W efekcie i w praktyce, w świetle obecnie obowiązujących przepisów prawnych nie może działać SI mająca osobowość prawną czy też prezentująca „autonomiczne decyzje”. Rozstrzygnięcia SI zawsze muszą być autoryzowane przez człowieka (przedsiębiorstwo) i to człowiek każdorazowo musi brać za nie odpowiedzialność. Porównać to można prawnie chociażby z odpowiedzialnością za produkt niebezpieczny, czy jakikolwiek wytwór/narzędzie danego człowieka czy przedsiębiorstwa. Powodem, dla którego dokonano powyższego rozstrzygnięcia, które na pierwszy rzut oka może wydawać się ograniczającym jest tzw. „czarna skrzynka” w kontekście AI (black box).

Czym jest czarna skrzynka w kontekście SI?

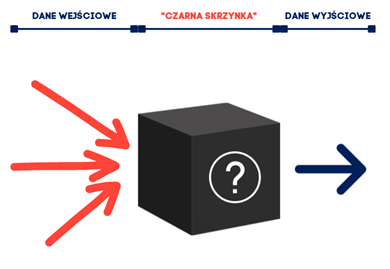

Określenie „czarna skrzynka” w kontekście SI oznacza, że sztuczna inteligencja nie zawiera w swoim sposobie funkcjonowania informacji o tym, jak osiągnęła postawiony przed nią cel. A także, jak „podejmowała decyzje” do tego celu prowadzące. Czyli, mówiąc prościej – znamy dane wejściowe i znamy wynik działań. Nie wiemy jednak (i nie jesteśmy w stanie się łatwo dowiedzieć), w jaki sposób SI uzyskała określony rezultat.

Taka cecha SI powoduje, że jest ona z natury nieaudytowalna. Wyjaśnienie jej funkcjonowania nie jest możliwe nawet dla jej twórców przy założeniu posiadania ograniczonych zasobów czasowych i finansowych. W efekcie, w sytuacji zakwestionowania wyników działania algorytmów danej SI przez osobę, która czuje się danym rozstrzygnięciem pokrzywdzona, mielibyśmy do czynienia z potencjalnym brakiem możliwości weryfikacji czy do takiej sytuacji faktycznie doszło. A z kolei gdyby za daną SI nikt nie ponosiłby odpowiedzialności, potencjalnie pokrzywdzony de facto nie byłby w stanie na własną rękę wykazać swoich racji. Nawet, gdyby obiektywnie miał słuszność.

Stąd założenie, że ograniczenia prawne nałożone na SI i odpowiedzialność jej twórców czy użytkowników (zwłaszcza komercyjnych) za jej działania, spowodują:

- dokładne testowanie i uczenie SI,

- używanie w obrocie tylko takich, których twórcy/użytkownicy są pewni (z uwagi na ryzyko biznesowe i prawne związane z komercyjnym używaniem),

- doprowadzenie do wzmożenia poszukiwań tzw. audytowalnej SI.

Wracając jednak do samej SI, powstaje pytanie z czego wynika tak kontrowersyjne działanie tej technologii. Powodem może być nadmierna (z punktu widzenia możliwości poznawczych człowieka) złożoność algorytmów. Jest to widoczne w przypadku SI opartej na głębokiej sieci neuronowej. Kolejnym powodem zaś może być opieranie SI na algorytmie uczenia maszynowego opartego na relacjach geometrycznych, niemożliwych do wizualizacji przez ludzi.

W praktyce, mając na uwadze, że tworzenie SI odwraca ogólnie przyjęty paradygmat programowania – dane wejściowe + algorytm na danych = oczekiwany rezultat – na dane wejściowe plus oczekiwany rezultat = algorytm na danych, audytowalna SI właściwie zaprzecza… idei SI. Czemu bowiem tworzyć technologię, która potrafi działać na poziomie szczegółowości i wolumenów danych niedostępnych ludzkim możliwościom kognitywnym oraz identyfikować w tych danych wzorce, a następnie używać tych wzorców do uzupełniania luk w danych oraz wnioskowania na przyszłość, skoro do zaudytowania i autoryzowania jej działania trzeba będzie czegoś w rodzaju kolejnej SI (potencjalnie równie nieaudytowanej).

Potencjalnie może to oznaczać, że wszelki zysk z zastosowania SI w danym przypadku praktycznym może zostać zniwelowany przesz koszt jej audytowania. Stąd, podejmowane są liczne próby stworzenia audytowalnej SI. Znacznie szerzej otworzyłoby to drogę tej technologii w obszarach regulowanych przez prawo i wrażliwych z punktu widzenia interesu społecznego.

A do czego może w praktyce prowadzić problem czarnej skrzynki pokazuje kilka historycznych i spektakularnych przykładów.

Czarna skrzynka w kontekście SI – przykłady

Branża finansowa

Jednym z ciekawszych przykładów jest incydent znany pod nazwą Flash Crash. W 2010 roku jeden z funduszy inwestycyjnych uruchomił algorytm sprzedaży kontraktów futures. Działał on w tempie określanym przez wolumen sprzedaży tych papierów wartościowych. Ponieważ eliminacja długich pozycji na tych kontraktach polegała na sprzedaży innym inwestorom instytucjonalnym, generowało to zwiększoną podaż, czyli nadpłynność rynku. Inni inwestorzy, wraz ze wzrostem podaży także zaczęli likwidować swoje zaangażowanie w kontrakty. Jeszcze bardziej napędzało to działanie algorytmu – uruchomiło to swego rodzaju „lawinę”.

Zanim zorientowano się w sytuacji, stracono kontrolę nad transakcjami w tym dniu. Zresztą, nie odzyskano jej (analiza sytuacji została przeprowadzona ex post), a algorytm sprzedaży wyłączył się samoczynnie o określonej godzinie. Nie można było na bieżąco analizować podejmowanych przez SI decyzji (wszystkie powyżej opisane spostrzeżenia są wynikiem analizy wstecznej). Dodatkowo, istnieje relatywnie mały margines czasowy dla ludzkiej interwencji w działanie algorytmu SI.

Branża medyczna

Kolejnym przykładem, jest projekt Deep Patient, uruchomiony w 2015 roku w szpitalu Mount Sinai w Nowym Jorku. SI, wytrenowana na bazie informacji pochodzących z kart zdrowia ponad 700 tysięcy pacjentów, nauczyła się stawiać zdumiewająco precyzyjne diagnozy. Co więcej, okazała się także doskonała w rozpoznawaniu schorzeń psychiatrycznych, w tym bardzo trudnej do diagnozy schizofrenii. Wydawać by się mogło, że precyzyjne i trafne diagnozowanie pacjentów to dobra wiadomość. Teoretycznie tak, problem jednak w tym, że ani lekarze, ani twórcy SI nie wiedzą, jak program dochodził do tych diagnoz. Dlatego też wyniki działań SI nie mogły stać się bazą np. do opracowania nowych form diagnozy.

Procesy rekrutacyjne

Problem „czarnej skrzynki” może także wiązać się z kwestiami dyskryminacji rasowej bądź ze względu na płeć. W 2018 roku na pierwsze strony gazet trafił Amazon, a konkretnie – stosowane w tej firmie oparte na SI narzędzie rekrutacyjne. Algorytm SI oparty był na bazie aplikacji składanych do Amazon w okresie poprzednich 10 lat. Niestety, rezultaty okazały się być dalekie od zadowalających. Po pewnym czasie okazało się, że narzędzie wyraźnie faworyzuje męskie kandydatury, znacznie utrudniając kobietom otrzymanie pracy w firmie. Ostatecznie narzędzie (które – co trzeba zaznaczyć – miało charakter eksperymentalny) zostało zamknięte.

Oczywiście, konsekwencje związane z problemem „czarnej skrzynki” nie zawsze muszą być dramatyczne i występować na dużą skalę. Nie zmniejsza to jednak ich dotkliwości dla potencjalnych odbiorców technologii opartych na SI. Weźmy przykład klienta rozwiązania finansowego opartego na SI, któremu odmówiono kredytu bądź ubezpieczenia. W przypadku oparcia się przy podejmowaniu takiej decyzji (niekorzystnej dla klienta) na algorytmach SI, powstaje problem po stronie dostawcy usługi. Musi on bowiem odtworzyć powody i ścieżki decyzyjne prowadzące do takiego, a nie innego rozstrzygnięcia przez SI przedmiotowej kwestii. A w przypadku „czarnej skrzynki”, jak już wiemy, działanie takie bywa skazane na niepowodzenie.

Rozwiązanie tego problemu nie jest tylko kwestią ochrony rynku oraz podmiotów z natury „słabszych”, czyli potencjalnych odbiorców usług opartych na SI. Także w interesie twórców implementacji sztucznej inteligencji oraz – idąc dalej – państwa powinno leżeć jego rozwiązanie. Można bowiem sobie wyobrazić, że duża liczba żądań mających na celu analizę powodów podejmowania przez SI określonych decyzji w tym samym czasie może narazić dostawcę rozwiązania na utratę reputacji i znaczne koszty operacyjne (a nawet bankructwo).

XAI zamiast czarnej skrzynki?

W związku z problemami „czarnej skrzynki” pojawiają się głosy o konieczności spopularyzowania nie tyle audytowalnej, co wytłumaczalnej AI (z ang. Explainable AI, XAI). XAI można rozumieć jako takie metody, które umożliwią ludziom zrozumienie wyników opracowanych przez algorytmy uczenia maszynowego. Co za tym idzie, ułatwią budowanie zaufania do takich wyników i, w konsekwencji, do idei AI jako takiej.

W kolejnym wpisie pokażemy, jakie wyzwania wiążą się wprowadzeniem XAI oraz jakie są perspektywy jej rozwoju.

Sprawdź także

https://eur-lex.europa.eu/legal-content/EN/TXT/?qid=1593073685620&uri=CELEX:52020DC0066 – KOMUNIKAT KOMISJI DO PARLAMENTU EUROPEJSKIEGO, RADY, EUROPEJSKIEGO KOMITETU EKONOMICZNO-SPOŁECZNEGO I KOMITETU REGIONÓW – Europejska strategia w zakresie danych

https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=63199 – Liability for Artificial Intelligence and other emerging digital technologies

https://ec.europa.eu/transparency/regdoc/rep/1/2018/PL/COM-2018-237-F1-PL-MAIN-PART-1.PDF – KOMUNIKAT KOMISJI DO PARLAMENTU EUROPEJSKIEGO, RADY EUROPEJSKIEJ, EUROPEJSKIEGO KOMITETU EKONOMICZNO-SPOŁECZNEGO I KOMITETU REGIONÓW – Sztuczna inteligencja dla Europy